ARTICOLO / 20 MAGGIO 2025

AI Act: la tua roadmap per uno sviluppo software a prova di compliance

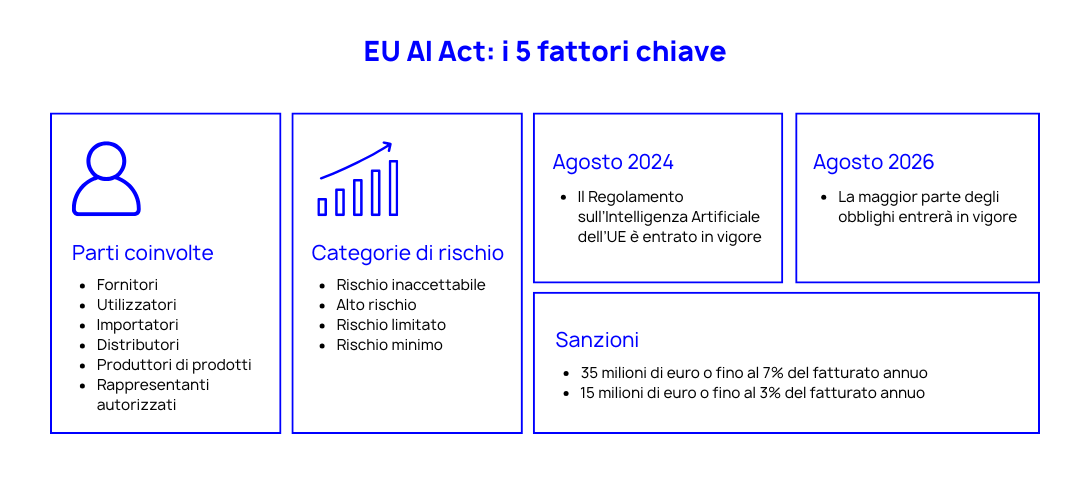

L'entrata in vigore dell'AI Act europeo segna un punto di svolta per lo sviluppo software che integra componenti di intelligenza artificiale. Nel tentativo di stabilire un quadro giuridico uniforme l’UE ha promosso l’adozione di una human-centered AI che sia affidabile e garantisca la protezione dei diritti fondamentali (salute, sicurezza, democrazia, tutela ambientale). Fornitori, distributori, deployer e importatori di sistemi AI immessi nell’UE o il cui utilizzo abbia effetti su persone in UE dovranno conformarsi agli obblighi previsti da questa normativa. Il mancato rispetto delle normative prevede sanzioni che possono arrivare fino a 35 milioni di euro o al 7% del fatturato annuo per le violazioni più gravi. Prepararsi adeguatamente è fondamentale. Se stai valutando come adeguare i tuoi processi di sviluppo e la tua infrastruttura, questa roadmap ti guiderà attraverso i requisiti chiave della normativa.

Timeline di implementazione: quando devi essere pronto

L'AI Act prevede un'implementazione graduale:

- 2 agosto 2025: si applicano gli obblighi specifici per i modelli general-purpose (GPAI)

- 2 agosto 2026: entrata in vigore della maggior parte degli obblighi (eccetto art 6)

- 2 agosto 2027: applicazione completa per i sistemi ad alto rischio (entra in vigore delle “Regole di classificazione per i sistemi AI ad alto rischio”)

Sono in vigore dal 2 febbraio 2025 gli obblighi relativi ai sistemi AI proibiti.

Cos’è un “sistema di AI” ai sensi dell’AI Act?

Principi per un AI Affidabile

- Supervisione Umana

- Responsabilizzazione

- Sicurezza e Robustezza

- Benessere ambientale e sociale

- Trasparenza

- Privacy, Integrità e governance dei dati (nel rispetto del GDPR)

Capire l'impatto dell'AI Act sul tuo software

La normativa classifica i sistemi di AI in categorie di rischio che determinano requisiti e obblighi specifici:

- Rischio inaccettabile: applicazioni proibite in quanto violano i diritti fondamentali

(ad es. sistemi di punteggio sociale, scraping non mirato e AI manipolativa) - Alto rischio: sistemi che impattano negativamente e in modo significativo su salute, sicurezza e diritti (Art 6 e allegato III - AI Act) - (ad es. l’AI usata in biometria, istruzione, infrastrutture critiche, come componente di sicurezza di un prodotto, profilazione per valutare il rendimento, l’affidabilità, la salute o gli interessi di persone fisiche)

- Rischio limitato: sistemi che non impattano gravemente sui diritti e libertà della persona; perciò, si limitano a introdurre obblighi di trasparenza verso l'utente

- Rischio minimo: tutti gli altri sistemi. Sottoposti ad obblighi generali di protezione dati, concorrenza, responsabilità civile e diritti dei consumatori conformemente alle legislazioni nazionali ed europee.

L'AI per scopi generali

La normativa introduce ulteriori obblighi specifici per i modelli di AI per scopi generali (GPAI) quali: fornire documentazione tecnica, istruzioni per l’uso, rispettare la direttiva sul copyright e pubblicare un riepilogo dei contenuti utilizzati per la formazione. Tali sistemi possono configurare un ulteriore categoria di rischio cosiddetto “sistemico”, che impone di: condurre valutazioni del modello, test avversari, monitorare e segnalare incidenti gravi e garantire protezioni per la sicurezza informatica.

Nella classificazione del tuo sistema bisogna tener conto di tutti i rischi noti e ragionevolmente prevedibili alla luce dello scopo previsto e dell’uso improprio ragionevolmente prevedibile. La corretta classificazione del tuo sistema di AI determinerà l'entità dell'impatto su attività, tempi e budget di sviluppo.

I pilastri della compliance tecnica

1. Analisi e Valutazione d'Impatto

- Valutazione della Conformità: verifica l’impatto in termini di compliance, all’inizio del progetto e ad ogni aggiornamento e modifica sostanziale allo scopo del sistema AI.

Contenuto:- Descrizione dei processi in cui sarà usato il sistema,

- Categorie di interessati,

- Descrizione dell’attuazione delle misure di controllo umano,

- Descrizione delle misure da adottare in caso di materializzazione dei rischi (Sistema di gestione del rischio)

- Periodo di tempo/frequenza in cui è destinato ad essere usato

- FRIA: valuta l’impatto sui diritti fondamentali prima di mettere in uso il sistema AI (obbligatoria per organismi di diritto pubblico, operatori privati che forniscono servizi pubblici, operatori che forniscono sistemi di AI ad alto rischio come banche ed assicurazioni)

- DPIA: Valutazione d’impatto sulla protezione dei dati, necessaria qualora siano trattati dati personali o sensibili ai sensi del GDPR (quali dati sono utilizzati? Quali misure adottiamo per prevenire le distorsioni? Come sono conservati? Da dove arrivano? Sono affidabili?)

Dall’analisi potrebbe emergere che alcuni sistemi di AI debbano recare una marcatura CE (fisica e/o digitale) per poter circolare liberamente nel mercato interno, oppure essere registrati nell’apposita Banca dati dell’UE.

2. Documentazione tecnica rafforzata

La documentazione deve essere redatta prima dell’immissione sul mercato del sistema, tenuta aggiornata e conservata (10aa), include:

- Descrizione generale del sistema di AI - Architettura completa e componenti AI utilizzati (scopo, come interagisce con altri sistemi e risorse computazionali e hardware, frequenza e misure di manutenzione, eventuali modifiche al sistema e alle sue prestazioni)

- Descrizione dettagliata del processo di sviluppo del sistema AI, comprese le specifiche di progettazione, i requisiti dei dati, le procedure di test, i casi limite e i criteri di accettazione (comprendere capacità e limiti)

- La documentazione deve inoltre includere informazioni sulle prestazioni del sistema e un piano per monitorarle dopo il suo lancio

- Procedure per la raccolta e gestione del feedback utente

- Metodologie di supervisione umana

- Strategie di gestione degli errori del sistema (gestione del rischio)

- Dataset di training e testing (processi di formazione e collaudo)

- Metriche di performance e risultati della validazione

3.Testing e validazione in sandbox

È necessario implementare ambienti di test conformi che garantiscano:

- Protezione da accessi non autorizzati

- Procedure regolari di backup dei dati

- Piani di ripristino rapido

- Strumenti per il rollback delle implementazioni

- Validazione completa su dataset diversificati

I sistemi di AI possono essere addestrati in spazi di sperimentazione normativa e di prova in condizioni reali, tali test non devono avere effetti negativi sugli utenti, perciò, i risultati oltre ad essere cancellati alla conclusione dei test, devono essere reversibili o ignorabili. A tal fine va prodotto un documento che ne descrive obiettivi, metodi, ambito geografico, popolazione e tempistiche, monitoraggio, organizzazione e svolgimento della prova in condizioni reali.

4. Supervisione umana efficace

I Sistemi di AI in particolare quelli ad Alto Rischio, devono essere sviluppati e progettati come strumenti al servizio delle persone, in modo da poter essere controllati e sorvegliati dagli esseri umani.

L’utente deve potersi opporre all’uso del sistema di AI.

La normativa richiede:

- Personale qualificato con la competenza, la formazione e l’autorità per la supervisione (comprendere il comportamento del sistema, la documentazione tecnica e le normative per mantenere il sistema di AI conforme).

- Analisi continua degli output AI

- Procedure di validazione strutturate

- Criteri chiari per l'intervento umano (human-in-the-loop, human-on-the-loop, human-in-command)

- Progettare il sistema AI con vincoli operativi intrinseci, che non possano essere ignorati dal sistema stesso e risponda all’operatore umano

5.Trasparenza

Per tutti i sistemi di AI bisogna:

- Prevedere misure che consentano la tracciabilità e spiegabilità del sistema di AI

- Progettare il sistema in modo che non possa creare contenuti illegali

- Etichettare i contenuti generati con AI (deep fake)

- Informare l’utente che si sta interagendo con un sistema di AI, dichiarando capacità e limiti dello stesso

- Pubblicare elenchi dei dati di training

L’utente deve poter presentare ricorso contro le decisioni prese dal sistema di AI, l’organismo responsabile della decisione deve pertanto essere identificabile e i processi decisionali devono essere spiegabili.

6. Qualità e sicurezza dei dati

È fondamentale garantire, in conformità con il GDPR, appropriate pratiche di gestione dei dati assicurando:

- Qualità dei dati di training e validazione (pertinenti, completi, privi di errori e non discriminatori)

- Procedure di pseudonimizzazione e cifratura

- Politiche di data retention conformi

- Sistemi di logging automatico degli eventi (conservati per almeno 6 mesi)

- Monitoraggio continuo delle performance

- Trasparenza in merito allo scopo originale per la raccolta

Adeguare l'infrastruttura

Per supportare in modo efficace lo sviluppo, il rilascio e il monitoraggio di sistemi AI conformi all’AI Act, è necessario che l’infrastruttura IT evolva secondo quattro direttrici fondamentali:

1. Architettura e processi a prova di AI

L’infrastruttura deve supportare pipeline CI/CD con step di validazione, ambienti di test conformi e sistemi di versioning per codice, modelli e dataset. Fondamentale garantire la tracciabilità, la replicabilità e la segregazione dei dati.

2. Sicurezza e resilienza by design

Backup, disaster recovery, accessi controllati, pseudonimizzazione e crittografia sono elementi imprescindibili. Serve predisporre test di robustezza (adversarial testing) e piani di risposta rapida a incidenti legati all’AI.

3. Strumenti per spiegabilità e controllo

Framework XAI (es. LIME, SHAP), logging centralizzato, audit trail e dashboard di governance aiutano a garantire trasparenza, accountability e supervisione continua del comportamento del sistema.

4. Monitoraggio continuo e feedback loop

I sistemi devono essere osservabili anche post-rilascio, con monitoraggio real-time delle performance, meccanismi di feedback strutturati e processi di notifica automatica verso le autorità in caso di incidenti gravi.

Adeguare l'infrastruttura: gli elementi chiave

- Strumenti di gestione del rischio: tecniche di fairness, bias mitigation e protezione dei dati, per prevenire effetti discriminatori e garantire l’affidabilità dei sistemi AI.

- Sistemi di versioning avanzati per modelli, dataset e codice, per assicurare tracciabilità, auditabilità e gestione strutturata degli aggiornamenti.

- Pipeline CI/CD con validation step: integrazione di controlli automatici per verificare la compliance, la robustezza e le performance prima del rilascio.

- Ambienti di staging conformi: isolati, sicuri e replicabili, pensati per testare i sistemi AI in condizioni controllate prima della messa in produzione.

- Sistemi di backup e disaster recovery: per garantire resilienza, continuità operativa e rollback rapido in caso di anomalie o malfunzionamenti.

- Strumenti di monitoring avanzato e audit periodici: per osservare il comportamento dei sistemi AI in tempo reale e verificare che non compromettano sicurezza e diritti fondamentali.

- Framework di trasparenza e spiegabilità (XAI): come LIME o SHAP, per rendere comprensibili le decisioni dei modelli e agevolare la supervisione umana.

Gestione dei ruoli e responsabilità

- Il tuo ruolo nella catena del valore AI (provider, deployer, importatore, distributore)

- Le responsabilità specifiche per ogni ruolo

- I processi di oversight e governance

- Le procedure di coordinamento con le autorità di vigilanza

- I piani di formazione del team

Prossimi passi pratici

- Analizza il tuo portfolio e classifica i sistemi AI

- Conduci una gap analysis sulla documentazione esistente

- Implementa gli ambienti di test conformi

- Stabilisci le procedure di supervisione umana

- Stabilisci politiche per garantire la qualità dei set di dati

- Stabilisco procedure per identificare, mappare e mitigare i rischi associati all’uso dei sistemi AI

- Aggiorna contratti e accordi con fornitori e partner

La compliance all'AI Act richiede un approccio strutturato ma gestibile. Con una pianificazione adeguata e gli strumenti giusti, puoi trasformare questo requisito normativo in un'opportunità per migliorare la qualità e l'affidabilità dei tuoi sistemi AI.

Il momento di agire è ora: mentre i dettagli implementativi della normativa vengono definiti, costruire fin da subito processi e infrastrutture robuste ti permetterà di affrontare con serenità le sfide della compliance ed evitare sanzioni significative.

AUTORI:

Elena Michelotto - Data & Low Development e Stefano Dindo - Head of Software Development